Azt eddig is tudtuk, hogy az iOS és macOS a vakok számára hihetetlenül kifinomult, out-of-the-box megoldásokat tartalmaz. Ha nem látsz, szinte biztos, hogy előbb-utóbb almás cuccokat veszel, annyira megkönnyítik az életed.

A fejlesztés pedig ezen a téren sem ért véget. Az iOS 13-ban például több fejlesztés is van ezen a téren, az egyik ilyen a gombok automatikus machine learning felismerése. Eddig, ha az iOS appokat író programozó nem írta bele a megfelelő attribútumba az adott gomb nevét (pl. vissza, menü, következő), akkor a VoiceOver nem tudta felolvasni, milyen gomb is az. És ez sokszor előfordult: az olyan mezőket, ami végül nem jelenik meg a végső programban, sok esetben nagyon elhanyagolják a fejlesztők.

Hogy mi ennek az eredménye?

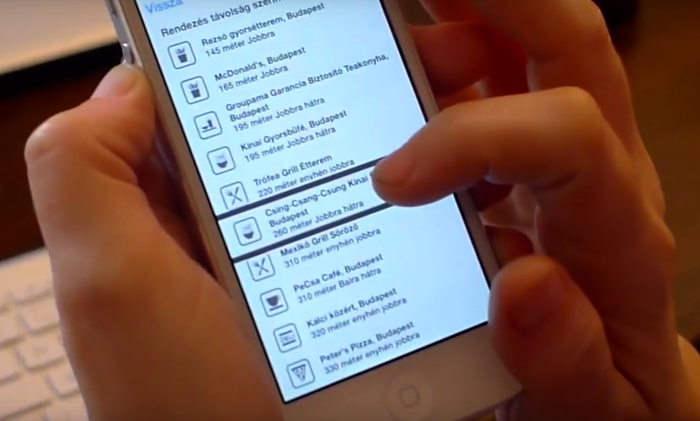

Egy vak, ahogy végighúzza az ujját a kijelzőn, a VoiceOver felolvassa neki az elemeket. Ha nem írják be a gombok nevét, ők csak azt hallják, hogy “gomb13, gomb 14”, stb. Csakhogy az iOS 13-tól a rendszer a gombra rajzolt alakzatok alapján megpróbálja kitalálni, mi is az.

“Gomb, esetleg Keresés“ - így fejezi ki a VoiceOver, hogy továbbra sem biztos benne, de szerinte Keresés gomb van az ujjunk alatt.

A fotók felismerésénél is volt javulás. Itt láthatjátok egy videóban, hogyan készítenek fotókat a látássérültek. Itt, valamint a fotók megosztásánál, és a sima tartalomfogyasztásnál is fontos, hogy a rendszer elmondja, mi is van nagyjából a képen. Eddig egy kép esetén olyanokat mondott a VoiceOver, hogy “kép, jól megvilágított, egy arc”. Most viszont már az újság olvasása közben azt hallhatjuk: “Egy személy, mosolyog és kanapé”, amennyiben a képen egy személy áll egy kanapé előtt.

A bejegyzés trackback címe:

Kommentek:

A hozzászólások a vonatkozó jogszabályok értelmében felhasználói tartalomnak minősülnek, értük a szolgáltatás technikai üzemeltetője semmilyen felelősséget nem vállal, azokat nem ellenőrzi. Kifogás esetén forduljon a blog szerkesztőjéhez. Részletek a Felhasználási feltételekben és az adatvédelmi tájékoztatóban.