Most már évek óta tart a jó szokás, hogy az adott évben nem a néhány hónap múlva megjelenő iPhone-okról olvashatunk találgatásokat, hanem már a jövő éviről. Hogy miért? Mert az azévit kitárgyaltuk tavaly, és már semmi újdonságot nem tud nyújtani. Egyébként is unalmas.

Mint ahogy idén is. Az idei iPhone felhozatalban ugyanúgy három modell lesz, nagyjából változatlan méretekkel, az XS és XS Max folytatásai kapnak egyedül izgalmas fejlesztést, a háromlencsés kamerát. Az egyetlen izgalom, hogy mire használja majd az Apple a három lencsét, de mivel ez szeptemberig nem derül ki, nincs több kitárgyalnivaló rajta. Minden más nagyjából ugyanaz: a kijelzők változatlan OLED-ek az XS sorozat folytatásánál, azzal a különbséggel, hogy az Apple kinyírja várhatóan a 3D Touch-ot. Helyette lesz a hosszú nyomás.

Üdvözlendő, hogy a mostani kib*ott csúszós hátlap helyett egy kifejezetten tapadós üveget terveznek, ezt betudjuk bugfixnek. Persze az A13 nagyon erős lesz, megint össze lehet vetni az asztali rendszerek számítási teljesítményével, ebből pedig semmit nem érzünk majd. Ja, lesz dupla Bluetooth-eszköztámogatás, és kábé ennyi.

Viszont jövőre valami megváltozik. Ming-Chi Kuo elemző szerint a 2020-as telefonok mérete

- 5,4 (a kisebbik XS, a mostani 5,8 col helyett)

- 6,7 (a nagyobbik XS, a mostani 6,5 helyett) és

- 6,1 colosak lesznek (ez lesz a mostani XR folytatása, változatlan mérettel)

Vagyis a két XS-t egyszerre növelik és csökkentik méretben, a legkisebb telefon így 0,4 collal lesz kisebb átmérőben, majdnem egy centivel lesz így kisebb a magassága. Ami nem tűnik így soknak, de azért az.

Ez azt jelenthetné, hogy az Apple meghallgatta a kisebb telefont igénylők óhaját, és gyártanak végre egy kézben használható készüléket. A rossz hír, hogy nem az iPhone XR folytatásának folytatását tervezik ilyenre, így esély sincs, hogy valami retró iPhone 5 dizájnt adjanak a cuccnak.

Azt gondolhatnánk, hogy az 5,4 colos kijelző még mindig nagyon nagy azoknak, akiknek beleférne ugyan egy kis nagyítás a 4 colhoz képest, de nem ennyi. Pedig valójában egy iPhone SE, sarkig húzott kijelzőkkel épp 5 colos készülék lenne. Vagyis az 5,4 colos 2020-as telefon pont az SE 2-re vágyók álmait célozza, csak épp nem retró dizájnnal, és nem budget árképzéssel.

Mégis: ez már valami. Jövőre, úgy tűnik, új telefonom lesz. (Addig is van nálam egy felújított SE, ha valakinek kellene használtan egy ilyen, írjon)

szucsadam

2019.06.17. 06:46

Címkék: vak ios13

Azt eddig is tudtuk, hogy az iOS és macOS a vakok számára hihetetlenül kifinomult, out-of-the-box megoldásokat tartalmaz. Ha nem látsz, szinte biztos, hogy előbb-utóbb almás cuccokat veszel, annyira megkönnyítik az életed.

A fejlesztés pedig ezen a téren sem ért véget. Az iOS 13-ban például több fejlesztés is van ezen a téren, az egyik ilyen a gombok automatikus machine learning felismerése. Eddig, ha az iOS appokat író programozó nem írta bele a megfelelő attribútumba az adott gomb nevét (pl. vissza, menü, következő), akkor a VoiceOver nem tudta felolvasni, milyen gomb is az. És ez sokszor előfordult: az olyan mezőket, ami végül nem jelenik meg a végső programban, sok esetben nagyon elhanyagolják a fejlesztők.

Hogy mi ennek az eredménye?

Egy vak, ahogy végighúzza az ujját a kijelzőn, a VoiceOver felolvassa neki az elemeket. Ha nem írják be a gombok nevét, ők csak azt hallják, hogy “gomb13, gomb 14”, stb. Csakhogy az iOS 13-tól a rendszer a gombra rajzolt alakzatok alapján megpróbálja kitalálni, mi is az.

“Gomb, esetleg Keresés“ - így fejezi ki a VoiceOver, hogy továbbra sem biztos benne, de szerinte Keresés gomb van az ujjunk alatt.

A fotók felismerésénél is volt javulás. Itt láthatjátok egy videóban, hogyan készítenek fotókat a látássérültek. Itt, valamint a fotók megosztásánál, és a sima tartalomfogyasztásnál is fontos, hogy a rendszer elmondja, mi is van nagyjából a képen. Eddig egy kép esetén olyanokat mondott a VoiceOver, hogy “kép, jól megvilágított, egy arc”. Most viszont már az újság olvasása közben azt hallhatjuk: “Egy személy, mosolyog és kanapé”, amennyiben a képen egy személy áll egy kanapé előtt.

szucsadam

2019.06.15. 11:05

Címkék: hirdető

Tart az AQUA péntek-szombati boltnyitási akciója a West End Business Center alján, a Westenddel szemben. Ma meglátogattam az új helyet.

A bolt kábé 80 négyzetméteres, de tágas érzést kelt, és elég menő kiállító bútorokkal, laptopállványokkal, okosóra-tartókkal mutatják be a termékeket. Van náluk Apple Watch is, de itt egy helyen át lehet nézni, meg lehet fogdozni a konkurenseket.

Tartanak a hétvégi akciók - még ma -, itt láthatjátok, mit kaphattok, mennyiért. Tök jó cuccok vannak, a Huawei okosmérlegét, ami a csontjaidról, zsírpárnáidról és izmaid állapotáról is nyilatkozik, és ha komolyan gondolod az edzést, nélkülözhetetlen infókat ad -, 10 ezer helyett ma még 7.990 forintért elvihető. Van nagyon olcsó okoskarkötő, egy rakás kiállított telefon (ki akarja megnézni a konkurens szuperkamerákat, Mate 20 Pro, anyone?).

Sőt, van elektromos roller is. El is kunyiztam, hogy kipróbáljam a közeljövőben, tartós teszten. Milyen hurcolászni, mennyire érezzük nehéznek, milyen könnyű összecsukni? Itt meg lehet nézni.

Dizájnos routerek is vannak:

Az egyik sarokban az EPSON állít ki nyomtatókat, az egyikről ma ingyen lehet nyomtatni fotót a betérő vendégeknek. Meglepődtem egyébként a gépen, mert ahelyett, hogy az elmúlt évtizedekben tapasztalható “beültetünk chipet és egyre drágábban adjuk a tintát” hozzáállás helyett itt már utántöltő flakonokat adnak el, amikkel a patron kiemelése nélkül spriccelhetjük be a festéket. A szintet pedig szabad szemmel láthatjuk, ezt imádom:

Szóval érdemes jönni, még vannak a készletekből, de azért mindig van egy-két vevő a boltban, szóval fogynak. Telefonáljatok ide előtte, ha jönnétek valami akciósért.

Disclaimer: az AQUA az Appleblog feat. Almalé és Kungfu partnere

szucsadam

2019.06.14. 12:32

Címkék: ios13

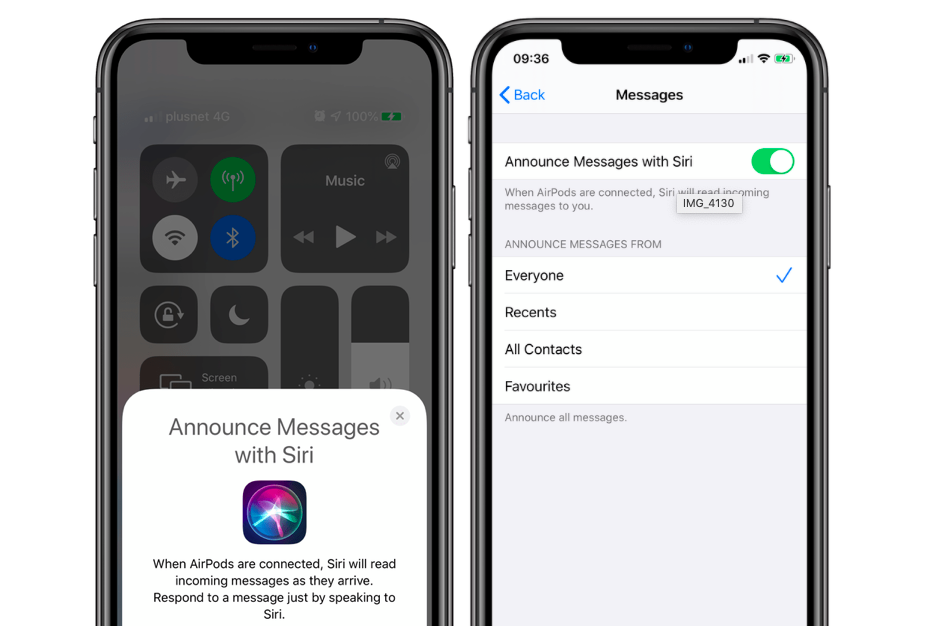

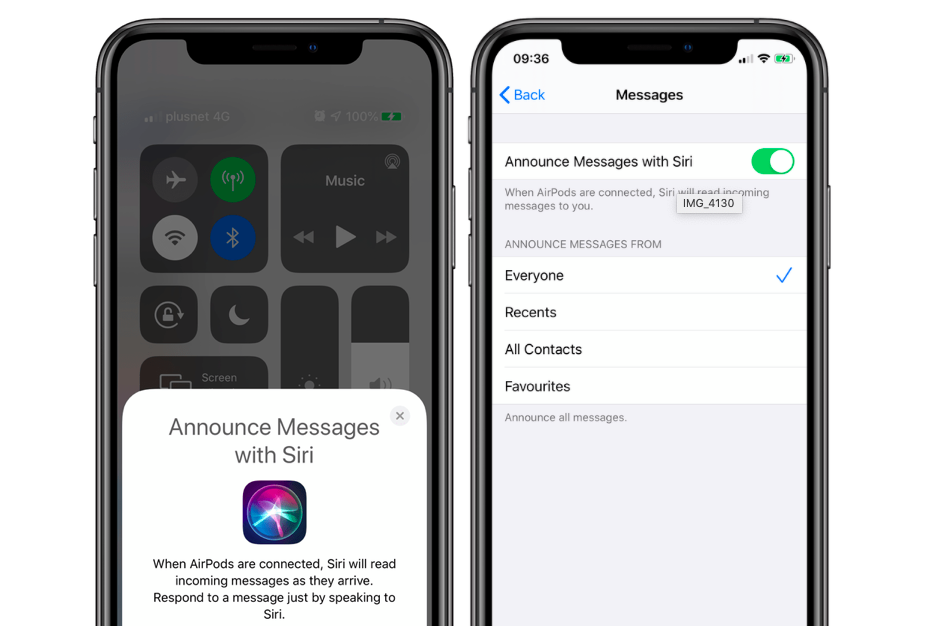

Az iOS 13-an, ha második generációs AirPods-od vagy Powerbeats Pród van, egy új ficsörrel találkozhatsz. Ez az Announce Messages, ami a kéz nélküli netezés új állomása lesz.

Az első alkalommal, amikor csatlakoztatod a fenti füleseket iOS 13-nál, felugrik egy kérdés: akarod engedélyezni az Announce Messages-t? Ha engedélyezed, onnantól a bejövő üzeneteidet felolvassa a Siri, kérdés nélkül, a füledre, és a felolvasás után egy hangjelzéssel értesít, hogy mostantól hallgatja a válaszodat. A választ speech-to-text-tel üzenetté alakítja, és válaszként elküldi.

A funkció az Apple Messages programjával és minden más programmal működik, ami felhasználja a SiriKit ide vonatkozó developer API-ját.

Szerencsére a funkció szűkíthető: beállítható, hogy minden üzenetet olvasson fel, vagy csak a legutóbbi beszélgetések folytatását, esetleg minden üzenetet a telefonkönyvünkben található kontaktoktól, vagy csak a kedvenc kontaktjaink üzenetét.

Sajnos azonban a felolvasást a Siri végzi, így a magyar nyelv nem lesz még támogatva.

A fura az egészben az, hogy a vakok a VoiceOver kisegítő lehetőséggel ma is magyarul olvastatják fel az üzeneteiket, gépi hanggal. Ha bejön egy üzenet, ráhúzzák az ujjukat, amire a hang felolvassa magyarul a magyar szöveget, akár az AirPods-ukra. A válasz gombra nyomva pedig diktálhatnak, az üzenetet pedig a küldés gombbal küldhetik. Három parancs - a VoiceOver-es dupla klikkek miatt összese 12 érintés -, ezt lehet megspórolni egy ilyen funkcióval.

De ez a VoiceOver. Nincs köze a Sirihez, gépi hangon beszél, kisegítő lehetőség. Mégis, hogy ennek a kényelemnek a közelébe érjünk, évekre lehet még szükség magyarul.